Guide de lecture critique des comparaisons indirectes

Accueil > Sommaire

> Analyse ajustée

Le guide de lecture critique proposé dans ce chapitre a pour objectif de vérifier si le travail de comparaisons indirectes analysé correspond à la situation idéale décrite dans la section suivante. Dans le cas contraire, les points « idéaux » non vérifiés représentent autant de réserves à émettre sur la validité des résultats disponibles.

1 Situation optimale

Pour être considéré comme acceptable, un résultat basé sur une comparaison indirecte devra vérifier les conditions suivantes :

· la comparaison indirecte a été effectuée avec une méthode statistique adaptée : comparaison indirecte ajustée, modèle linéaire mixte, méthodes Bayesiennes, méta-régression, etc.

· Une méta-analyse satisfaisante a été réalisée pour recueillir les essais contribuant aux comparaisons indirectes (recherche exhaustive des essais publiés et non publiés, sélection rigoureuse sur la qualité méthodologique des essais et une analyse poussée de l’hétérogénéité pour documenter l’hypothèse de stabilité des effets, cf. infra).

· Les essais ayant participé aux comparaisons indirectes sont comparables en terme de traitements (dose, régime d’administration), de contextes cliniques (traitements concomitants y compris interventions autres que médicamenteuses), de pathologies (définition, critères diagnostiques, critères de gravité et évolution de la pathologie), de chronologie (même ère thérapeutique et même tendance séculaire). Les analyses en sous groupes des études sont rassurantes sur l’absence d’hétérogénéité de l’effet traitement en fonction de ces covariables.

· Plusieurs chemins sont disponibles dans le réseau d’essais pour réaliser les mêmes extrapolations. Les données permettent de tester l’incohérence de manière relativement satisfaisante et aucune incohérence n’a été détectée s’ils existent plusieurs chemins.

· les résultats de comparaisons directes existants ne diffèrent pas du résultat de la comparaison mixte (« Mixed treatment comparison ») obtenues en combinant les comparaisons indirecte et directe qui sera mis en avant.

· L’interprétation des résultats est correcte. En particulier, aucune conclusion d’équivalence n’est effectuée à partir d’un constant d’absence de différence.

2 Guide de lecture critique

Le guide de lecture critique d’un résultat obtenu par comparaison indirecte proposée ici comprend 6 grandes parties destinées à vérifier :

1. l’acceptabilité de l’approche utilisée

2. le processus de recherche et de sélection des données contribuant aux calculs de comparaison indirecte

3. l’homogénéité clinique des essais et la stabilité des effets

4. la cohérence des estimations

5. le degré de concordance du résultat avec celui des comparaisons directes existantes

6. l’interprétation correcte des résultats dans les conclusions proposées

2.1.1 Analyse de l’approche utilisée

Lors de la lecture critique, le premier point à vérifier est qu’une méthode adaptée de comparaison indirecte a bien été employée. Ce point consiste à exclure l’utilisation des méthodes inappropriées de comparaisons indirectes. Toutes les autres méthodes (cf. supra) sont acceptables.

i. Rejeter une approche de comparaison naïve des estimations ponctuelles issues d’essais contrôlés distincts

Il faut rejeter une approche où les estimations ponctuelles sont comparées les unes aux autres sans tenir compte de leurs intervalles de confiance. Un exemple de résultats de ce type est donné dans l’étude de cas de la section 3.1.1.

ii. Rejeter une approche de comparaison naïve des bras actifs issus d’essais contrôlés distincts

Il faut rejeter une approche où les différents bras actifs des essais sont comparés, sans tenir compte des bras contrôles, rompant la randomisation.

Un exemple est donné dans l’étude de cas de la section 3.1.2.

2.1.2 Analyse de la recherche et de la sélection des essais inclus

Cette étape s’interroge sur le processus de constitution de la liste des essais participant aux méta-analyses nécessaires aux calculs de comparaison indirecte : s’agit-il d’essais sélectionnés pour donner les résultats de comparaisons indirectes souhaités ou s’agit-il de tous les essais à l’abri des biais réalisés dans le domaine ?

i. S’assurer que la recherche des essais a été exhaustive

Un processus de recherche exhaustive rigoureuse et reproductible des essais de type méta-analyse a-t-il été suivi avec utilisation de plusieurs sources ?

Les essais non publiés ont-ils été recherchés ? Les comparaisons indirectes sont sensibles, comme les méta-analyses classiques, au problème du biais de publication.

ii. Écarter une sélection opportune des essais

Il s’agit d’écarter la possibilité d’une sélection dirigée des essais en fonction du résultat escompté. Ici, l’analyse critique est identique à celle d’une méta-analyse. De fortes réserves devront être émises en cas d’absence de critères de sélection des essais ou d’utilisation de critères de sélection arbitraires.

A ce niveau, le travail de comparaison indirecte doit présenter les mêmes propriétés qu’une méta-analyse classique. L’analyse de la liste des essais exclus et des raisons d’exclusion est une aide utile pour l’analyse de la sélection des essais dont la qualité méthodologique garantit suffisamment l’absence de biais.

iii. S’assurer que toutes les comparaisons de base utilisables ont été considérées dans la sélection des essais

Un point en relation avec la recherche d’une incohérence (voir infra) est de s’assurer que toutes les comparaisons de bases utilisables pour faire la comparaison indirecte recherchée ont bien été incluses. Pour la comparaison indirecte A vs B, les comparaisons de base utilisables peuvent être multiples : A vs PBO et B vs PBO mais aussi A vs D et B vs D, etc… Plus la diversité des comparaisons de base sera grande, plus le travail sera à même de tester avec puissance l’hypothèse d’incohérence.

2.1.3 Analyse de l’homogénéité clinique des essais et de la stabilité des effets

Cette étape vérifie que les essais recherchés et inclus, cherchaient tous à répondre à la même question clinique au niveau du type de patients étudiés et des traitements comparés. Cette analyse vérifiera aussi les conditions d’acceptabilité de l’hypothèse de stabilité des effets au travers des essais fournissant les comparaisons de base.

i. Homogénéité des traitements étudiés dans les essais

Les essais ont-ils étudié les mêmes modalités de traitements (en termes de dose, de régime d’administration) ? L’exemple de l’association de la codéine au paracétamol illustre parfaitement ce point.

ii. Absence de facteur d’interaction ou homogénéité des populations vis à vis des variables d’interaction

Afin de vérifier la plausibilité de l’hypothèse de stabilité des effets indispensable à la validité des comparaisons indirectes (l’effet de A aurait été le même dans les essais de B versus contrôle que celui donné par les essais de A versus contrôle et vice-versa pour B.

Il convient de vérifier que les analyses en sous-groupes réalisées dans les essais ne révèlent pas de variable d’interaction, modifiant l’effet des traitements. Si de telles variables existent, la validité des comparaisons indirectes peut être remise en question s’il s’avère que les populations des essais de A versus contrôle et de B versus contrôle ne sont pas comparables vis à vis de ces covariables.

L’étude de cas de la section 3.1.7 donne un exemple de situation posant un problème d’interaction en comparaison indirecte.

iii. Absence d’hétérogénéité statistique entre les études d’une même comparaison

La présence d’une hétérogénéité des résultats statistiques cliniquement signifiante entre les essais de A versus contrôle ou de B versus contrôle est susceptible de remettre en question l’hypothèse de stabilité des effets. En effet, si la méta-analyse trouve une hétérogénéité des résultats des essais effectuant la même comparaison, cela est évocateur d’une variabilité des effets d’un essai à l’autre, donc de l’existence de facteur(s) d’interaction.

En absence d’hétérogénéité, il n’a pas été possible de mettre en évidence de modification de l’effet d’un essai à l’autre. Si certains essais de A et de B se recoupent en termes de contextes et de types de patients, cela suggère que l’hypothèse de stabilité des effets peut être raisonnablement acceptée.

2.1.4 Analyse de l’hypothèse de cohérence

Le résultat d’une comparaison indirecte n’a de sens que si ce résultat est retrouvé à l’identique quel que soit l’enchaînement de comparaisons utilisé pour l’obtenir, c’est-à-dire que si l’hypothèse de cohérence est vérifiée. Un résultat de comparaison indirecte sera d’autant plus fort que l’absence d’incohérence aura pu être éprouvée avec puissance. Des réserves seront à émettre chaque fois qu’une incohérence (cliniquement pertinente) aura été détectée ou qu’il n’aura pas été possible de la rechercher.

Ce point est à analyser pour chaque comparaison indirecte présente dans un travail car il concerne les résultats et non pas seulement la méthode.

i. L’incohérence a-t-elle été testée ?

Était-il prévu de tester l’incohérence ? La méthode utilisée permet-elle de la tester ?

ii. Le test de l’incohérence avait-il une efficacité minimale ?

La possibilité de mettre en évidence un défaut de cohérence va dépendre du nombre d’essais effectuant les mêmes comparaisons et de la diversité des comparateurs pivots (chemins de comparaisons indirectes). En cas d’existence d’un seul chemin (A vs PBO et B vs PBO) l’incohérence n’est pas testable (seul est testable l’hétérogénéité des estimations des deux types de comparaisons).

2.1.5 Analyse de la méthode statistique mis en œuvre

Ce point est le plus technique du guide de lecture. Il a pour objectif de vérifier que la mise en œuvre de la méthode statistique utilisée est satisfaisante. L’existence de ce point dans le guide est justifiée par le fait que certaines des méthodes de comparaisons indirectes sont de mise en œuvre délicate, en particulier celle faisant appel aux méthodes d’estimation par méthode de Monte Carlo et chaînes de Markov (MCMC) et Gibbs sampling. En pratique le recours à une expertise statistique est souvent nécessaire pour juger de l’acceptabilité technique d’un résultat de ce type.

Pour les méthodes utilisant l’estimation par MCMC et Gibbs sampling.

Un diagnostic de convergence a-t-il était effectué ? Dans l’idéal ce diagnostic fait appel à au moins une analyse graphique de l’historique de deux chaines. L’utilisation d’outils de diagnostic comme CODA ou BOA est fortement souhaitable.

Les résultats obtenus sont-ils indépendants des « a priori » choisis ? Une étude de sensibilité des résultats aux « a priori » est indispensable, avec démonstration que les résultats sont indépendants du choix des « a priori ».

Les « a priori » choisis sont-ils vraiment non informatif ? En général, il est recommandé d’utiliser au moins pour les distributions normales une variance de 100 et pour les précisions une distribution gamma (0·0001, 0·0001). En particulier il convient d’écarter les situations où l’obtention de la convergence nécessite l’utilisation d’un « a priori » informatif.

Un exemple d’utilisation satisfaisante de ces méthodes est rapporté dans l’étude de cas de la section 3.1.5.

2.1.6 Les résultats des comparaisons indirectes sont-ils renforcés par la disponibilité de comparaisons directes

i. Y a t-il des comparaisons directes ?

Les essais de comparaisons directes ont-ils été recherchés ?

ii. Y a-t-il concordances des estimations des comparaisons directes et indirectes ?

Les estimations des comparaisons directes sont-elles compatibles avec celles des comparaisons indirectes ou mixtes ? Cette concordance est évaluée à l’aide d’un test d’hétérogénéité des 2 types d’estimations.

iii. Le résultat mis en avant inclut-il les comparaisons directes ?

En cas de disponibilité d’essais de comparaisons directes, le résultat mis en avant les intègre-t-il (« mixed treatment comparison ») ? En effet, dans ce cas, la meilleure estimation possible est celle qui englobe l’ensemble de l’information disponible.

2.1.7 Interprétation des résultats

i. Aucune conclusion d’équivalence n’a été faite à partir de résultat non significatif

La conclusion d’absence de différence d’efficacité à partir de résultats de comparaison indirecte non significatifs est abusive. La problématique est strictement identique à celle rencontrée dans un essai thérapeutique non concluant.

ii. Aucune hiérarchie n’est proposée à partir de comparaisons naïves des estimations ponctuelles

Il existe un risque de hiérarchiser les traitements concurrents par un processus de comparaisons naïves des estimations ponctuelles lors de comparaisons indirectes basées sur des réseaux. Dans ce cas, la conclusion pose les problèmes évoqués dans la section ???, même s’il y a utilisation sous-jacente d’une méthode appropriée de comparaison indirecte.

3 Études de cas

Ces études de cas ont pour objectif d’illustrer certains points du guide de lecture critique en explicitant les concepts par l’exemple.

3.1.1 Exemple de comparaison naïve des estimations ponctuelles

Un exemple de comparaison indirecte inappropriée par simple comparaison des estimations ponctuelles est donné par une méta-analyse s’intéressant à la prévention des thromboses veineuses profondes à la phase aigue de l’accident vasculaire cérébral (AVC) (1).

La

conclusion de l’article est « Indirect comparison of

low and high doses of UFH and LMWH suggests that low-dose LMWH have the best

benefit/risk ratio in patients with acute ischemic stroke by decreasing the

risk of both DVT and pulmonary embolism, without a clear increase in ICH or

ECH. ».

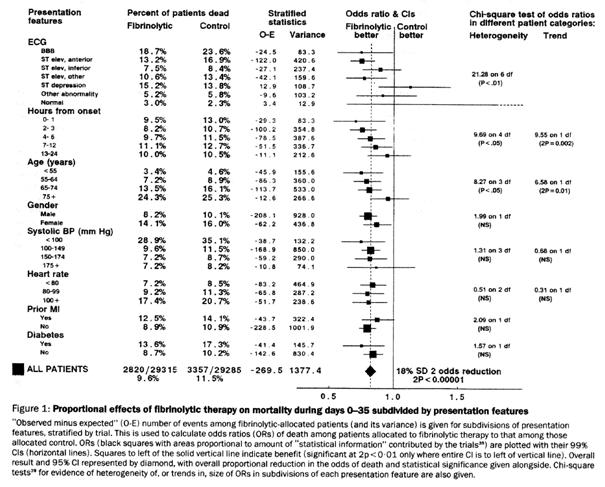

Ce travail a comparé les faibles et fortes doses d’héparine (non fractionnée ou de bas poids moléculaires) dans la prévention des thromboses veineuses profondes à la phase initiale de l’AVC. La méta-analyse est réalisée en sous-groupes d’essais comme le montre la Figure 1. Les résultats obtenus sur l’ensemble des critères de jugements sont résumés dans le Tableau 1.

Figure 1 – Analyse en sous-groupes en fonction de la dose d’anticoagulant ((1))

Tableau 1 – Ensemble des résultats de la méta-analyse en sous groupes d’essais en fonction de la dose ((1))

3.1.1 Exemple de comparaison naïve des bras actifs issus d’essais contrôlés

Une méta-analyse publiée en 2005 dans Ophtalmology (2) donne un exemple de comparaison indirecte inappropriée. L’objectif de cette méta-analyse était de comparer l’efficacité sur la pression intra oculaire (PIO) des différents traitements couramment utilisés dans le glaucome.

Le Tableau 2 donne pour chaque essai inclus dans la méta-analyse les traitements qu’il a comparés. Le Tableau 3 présente les moyennes des changements avant-après de pression intra oculaire observées dans les différents bras de ces essais, chaque traitement ayant été analysé sans tenir compte du bras contrôle. Ce tableau est ensuite utilisé pour ordonner les traitements d’après ces valeurs de changement conduisant à la conclusion de l’abstract « This meta-analysis suggests that bimatoprost, travoprost, latanoprost, and timolol are the most effective intraocular pressure–reducing agents in POAG and OH patients ».(2)

Tableau 2 – Liste des essais inclus dans la méta-analyse et traitements comparés dans ces essais

Tableau 3 – Tableau de résultats de la méta-analyse

Cette approche est inappropriée car elle rompt la randomisation et revient à présenter des valeurs de nature observationnelle sans aucune prise en compte des facteurs de confusion à l’aide des groupes contrôles. On s’attendrait à trouver, dans le tableau de résultats, des estimations d’efficacité par comparaison de traitements et non pas des estimations rattachées à un seul traitement (sans mention du comparateur).

3.1.2 Exemple de comparaison indirecte ajustée

La méta-analyse réalisée par Zhou et al. sur les statines en prévention cardiovasculaire a utilisé des comparaisons indirectes ajustées (3). Le ??? rapporte, pour chaque critère de jugement, les résultats des comparaisons de base (simvastatine vs pravastatine et atorvastatin vs pravastatine) et le résultat de la comparaison indirecte ajustée atorvastatine vs pravastatine.

Figure 2 – Résultats de la méta-analyse de Zhou et al.

3.1.3 Exemple de comparaison « mixed treatment comparison »

Un exemple d’utilisation des « mixed treatment comparison » (MTC) est donné par la comparaison de trois chimiothérapies de seconde ligne dans le cancer ovarien : le topotecan, le paclitaxel et le PLDH (liposomes pégylés contenant de la doxorubicine) (4).

Trois essais sont disponibles documentant les 3 comparaisons 2 à 2 possibles avec ces 3 traitements (Figure 3). Les résultats de ces 3 essais sur la mortalité totale montrent une incohérence étant donné que topotecan apparait inférieur au paclitaxel tout en étant supérieur au PLDH alors que paclitaxel apparait inférieur au PLDH (Figure 4).

La réalisation de MTC permet de réconcilier ces résultats en ne montrant plus aucune différence statistiquement significative entre ces 3 traitements (Figure 5), pouvant faire émettre l’hypothèse que l’incohérence initiale provenait du hasard.

Figure 3 – Essais disponibles et comparaisons directes réalisées ((4))

Figure 4 – Résultats des essais de comparaison directe ((4))

Figure 5 – Résultats des « mixed treatment comparison » combinant les 3 essais (3ème colonne) ((4))

3.1.4 Exemple d’utilisation satisfaisante d’une méthode d’estimation basée sur une méthode de MCMC (méthode de Monte Carlo par chaînes de Markov)

La méta-analyse de Babapulle et coll.

portant sur les stents enrobés donne un bon exemple d’utilisation

satisfaisante d’une méthode de MCMC. Leur description de la

méthode nous montre que les a priori utilisés étaient

suffisamment non informatifs, et nous précise que le résultat est

insensible aux « a priori » utilisés. Seul manque le diagnostic de

convergence.

« Substantive prior knowledge can thereby be included into any Bayesian analysis by choice of initial (pre-data) distribution. However, because we incorporated all relevant past studies, we wanted our final (posterior) distribution to reflect the information in our dataset only and not to be influenced by our choice of initial (prior) distribution. Therefore, low-information prior distributions were used throughout, so that the data from the trials dominated the final inferences. In particular, we used normal (mean=0, variance=100) prior distributions for all means and gamma (0·0001, 0·0001) prior distributions for all precisions (which is defined as the reciprocal of the variance). Sensitivity analyses with different choices of low-information prior distributions showed robustness to this choice. In particular, a wide range of low-information values used for our gamma distributions did not change any of our posterior inferences. Therefore, our estimates of odds ratios and their associated 95% credible intervals (which are the Bayesian equivalent of standard confidence intervals) were not unduly affected by our choice of prior distribution. Inferences were calculated with the Gibbs sampler programmed in WinBUGS software (version 1.4, MRC Biostatistics Unit, Cambridge, UK) »(5)

La méta-analyse sur les défibrillateurs implantables de Lam et Owen (6) donne aussi un exemple de méthode aussi bien pour le choix des a priori :

« To ensure that overall effects were dominated by data from the trials and not influenced by choice of initial distribution we used low information (noninformative) prior distributions—that is, we used vague normal (mean 0, variance 10 000) and uniform (0-2) prior distributions for means and standard deviations, respectively. We examined the impact of different choices of prior distribution in sensitivity analyses. »,

que pour le diagnostic de convergence des chaines :

« The Bayesian models were implemented

using WinBUGS version 1.4.1 (Imperial College and Medical Research Council,

2004). After convergence was achieved from an initial 5000 (burn-in)

simulations, we constructed posterior distributions of the treatment effects

from three chains of 50 000 simulations. MATLAB version 7.0 (MathWorks, Natick,

MA, 2004) was used to carry out diagnostics and further data

analyses. »

3.1.5 Étude de cas sur l’incohérence

La méta-analyse en réseau sur l’effet préventif des antihypertenseurs sur l’apparition du diabète illustre la gestion attendue de l’incohérence dans ce type de travail (7).

Le résumé précise « With an initial

diuretic as the standard of comparison (eight groups), the degree of incoherence

(a measure of how closely the entire network fits together) was small

(ω=0·000017, eight degrees of freedom). »

De plus, ce travail était à même de tester l’incohérence avec efficacité en raison de l’existence de nombreux chemins disponibles (y compris des chemins issus de comparaisons directes) pour chaque comparaison indirecte (cf. figure).

Par exemple, l’estimation de l’efficacité des IEC par rapport aux diurétiques thiazidiques peut s’effectuer par au moins 4 chemins principaux :

· le chemin direct IEC vs diurétique (2 essais)

· le chemin IEC vs placebo (3 essais) et placebo vs diurétique (3 essais)

· le chemin IEC vs bétabloquant et bétabloquant vs diurétique

· le chemin IEC vs calcium bloqueur (CCB) (3 essais) et CCB vs diurétique (2 essais)

· Et même les chemins IEC vs CCB, CCB vs ARB et ARB vs diurétique ou IEC vs CCB, CCB vs placebo et placebo vs diurétique, etc…

Figure 6 – Réseau de comparaison de la méta-analyse de Elliot et al. ((6))

3.1.6 Interaction et hypothèse de stabilité des effets

Pour

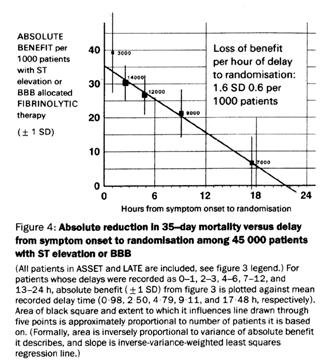

Si le fibrinolytique A a été évalué dans un essai versus placebo où le délai moyen depuis le début des symptômes était de 3h, son résultat ne pourra pas être combiné avec celui d’un essai de B versus placebo où le délai moyen était de 12h. Il n’est en effet plus possible d’accepter l’hypothèse de stabilité des effets dans cette configuration.

À effet des fibrinolytiques A et B identique et égal à l’effet moyen de tous les fibrinolytiques mesuré dans la méta-analyse, une réduction de mortalité d’environ 28% sera observée dans l’essai de A, tandis qu’elle sera de 15% dans l’essai de B, faisant apparaître une supériorité de A sur B lors de la comparaison indirecte.

Figure 7 – Mise en évidence de l’interaction entre la réduction de mortalité et le délai depuis le début des symptômes

Figure 8 – Quantification de la relation entre réduction de mortalité et délai entre le début des symptômes et la fibrinolyse

4 Références

1. Kamphuisen PW, Agnelli G. What is the optimal pharmacological prophylaxis for the prevention of deep-vein thrombosis and pulmonary embolism in patients with acute ischemic stroke? Thromb Res 2007;119(3):265-74.

2. van der Valk R, Webers CA, Schouten JS, Zeegers MP, Hendrikse F, Prins MH. Intraocular pressure-lowering effects of all commonly used glaucoma drugs: a meta-analysis of randomized clinical trials. Ophthalmology 2005;112(7):1177-85.

3. Zhou Z, Rahme E, Pilote L. Are statins created equal? Evidence from randomized trials of pravastatin, simvastatin, and atorvastatin for cardiovascular disease prevention. Am Heart J 2006;151(2):273-81.

4. Griffin S, Bojke L, Main C, Palmer S. Incorporating direct and indirect evidence using bayesian methods: an applied case study in ovarian cancer. Value Health 2006;9(2):123-31.

5. Babapulle MN, Joseph L, Belisle P, Brophy JM, Eisenberg MJ. A hierarchical Bayesian meta-analysis of randomised clinical trials of drug-eluting stents. Lancet 2004;364(9434):583-91.

6. Lam SK, Owen A. Combined resynchronisation and implantable defibrillator therapy in left ventricular dysfunction: Bayesian network meta-analysis of randomised controlled trials. Bmj 2007;335(7626):925.

7. Elliott WJ, Meyer PM. Incident diabetes in clinical trials of antihypertensive drugs: a network meta-analysis. Lancet 2007;369(9557):201-7.

8. Indications for fibrinolytic therapy in suspected acute myocardial infarction: collaborative overview of early mortality and major morbidity results from all randomised trials of more than 1000 patients. Fibrinolytic Therapy Trialists' (FTT) Collaborative Group. Lancet 1994;343(8893):311-22.

Interprétation

des essais cliniques pour la pratique médicale

www.spc.univ-lyon1.fr/polycop

Michel Cucherat

Faculté de Médecine Lyon - Laennec

Mis à jour : aout 2009